TensorFlowによるニューラルネットでMNISTの画像認識

今回は、TensorFlowでディープラーニングについてメモします。

ディープラーニング、ディープニューラルネットワークをDNNを略します。

今までは、Kerasでネットワークを構築、学習させていました。

今回は、TensorFlowを使います。

学習対象

学習対象は、MNISTの手書き数字です。

TensorFlow

TensorFlowを独断的に説明します。

(あくまで私の意見なので鵜呑みにはしないでくださいね)

TensorFlowは、機械学習、特にニューラルネットワークで使用されるライブラリです。

ニューラルネットワークにおいて、効率的にモデルの構築・学習することができます。

計算グラフ(私はよくわかっていません)を使っているので、計算が高速

このブログで扱っていたKerasは、TensorFlowの利用しています。

難易度としては、

TensorFlow > Kerasという認識です。

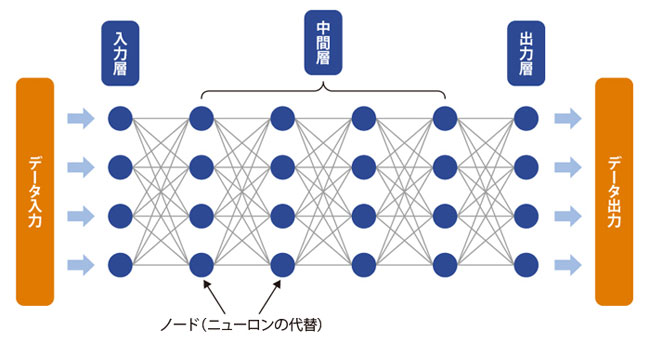

DNNのモデル構成

※下の画像はイメージです。今回構築するモデルではありません。

入力層

MNISTの手書き数字は、28×28の784です。

ニューロン素子:784

中間層

1層

ニューロン素子:64

出力層

MNISTの手書き数字は、0〜9までなので、10にカテゴライズできる。

ソフトマックス関数を使って、出力を割合として出す。

ニューロン素子:10

プログラム

#MNISTパッケージ

from tensorflow.examples.tutorials.mnist import input_data

import tensorflow as tf

#入力データを定義

x = tf.placeholder(tf.float32, [None, 784])

#入力層から中間層

w_1 = tf.Variable(tf.truncated_normal([784, 64], stddev=0.1), name="w1")

b_1 = tf.Variable(tf.zeros([64]), name="b1")

h_1 = tf.nn.relu(tf.matmul(x, w_1) + b_1)

#中間層から出力層

w_2 = tf.Variable(tf.truncated_normal([64, 10], stddev=0.1), name="w2")

b_2 = tf.Variable(tf.zeros([10]), name="b2")

out = tf.nn.softmax(tf.matmul(h_1, w_2) + b_2)

#誤差関数

y = tf.placeholder(tf.float32, [None, 10])

loss = tf.reduce_mean(tf.square(y-out))

#訓練

train_step = tf.train.GradientDescentOptimizer(0.5).minimize(loss)

#評価

correct = tf.equal(tf.argmax(out, 1), tf.argmax(y,1))

accuracy = tf.reduce_mean(tf.cast(correct, tf.float32))

#初期化

init = tf.global_variables_initializer()

#実行

with tf.Session() as sess:

sess.run(init)

#テストデータをロード

test_images = mnist.test.images

test_labels = mnist.test.labels

for n in range(20):

Epoc = n+1

print('Epoc %d' % Epoc)

for i in range(10000):

step = i + 1

train_images, train_labels = mnist.train.next_batch(100)

sess.run(train_step, feed_dict={x:train_images, y:train_labels})

if step % 1000 == 0:

acc_val = sess.run(accuracy, feed_dict={x:test_images, y:test_labels})

print('Step %d: accuracy = %.2f' % (step, acc_val))